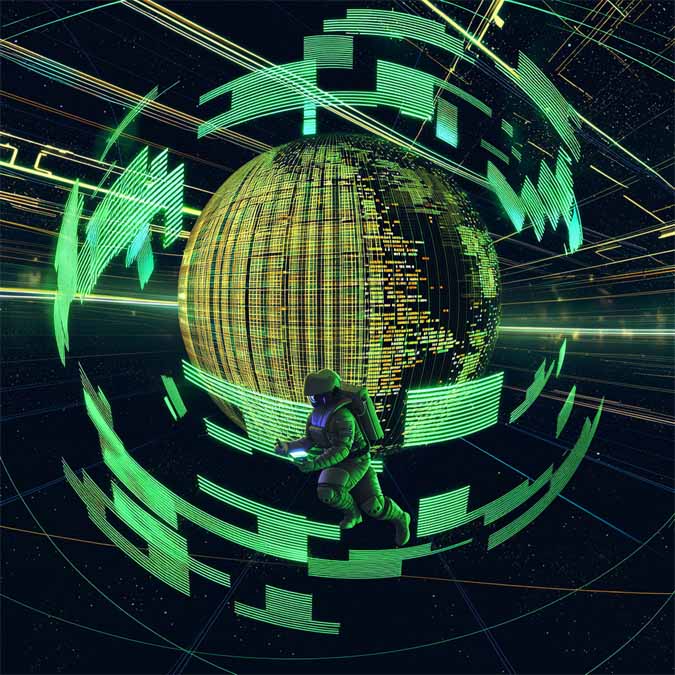

高通发布AI200与AI250数据中心芯片,单卡支持768GB LPDDR5内存

高通正式推出AI200与AI250两款数据中心加速器,产品核心聚焦内存容量与数据传输效率。其中,AI200加速器卡支持高达768GB LPDDR内存,可减少大型语言模型与多模态模型运行所需的硬件部件数量,同时避免频繁的卡外数据传输。

AI250则采用近内存计算布局,该设计旨在提升推理过程中的有效内存带宽。推理场景中,工作负载常因反复访问键值缓存而陷入停滞,这一架构恰好可解决此问题。高通表示,该架构能使有效内存带宽提升 10 倍以上,同时降低功耗。

高通CEO Cristiano Amon表示:“高通推出基于AI200与AI250芯片的加速器卡及整机柜产品,为数据中心AI工作负载提供行业领先的机柜级推理性能与内存效率。”

两款产品均提供加速器卡与全液冷机柜两种形态。机柜采用PCIe接口实现纵向扩展配置,通过以太网构建横向扩展集群。单个整机柜的功耗为160千瓦,与其他厂商现有GPU推理机柜处于同一级别。产品上市将分阶段推进,AI200计划于2026年推出,AI250则预计在2027年上市。此外,高通还披露其数据中心产品路线图将保持年度更新节奏,并确认HUMAIN为早期客户之一,该客户计划部署的容量最高可达200兆瓦。

各厂商数据中心芯片内存规格对比

AMD Instinct MI350X:288GB HBM3e内存,带宽8TB/s;其继任型号MI400最高将支持 432GB 内存

NVIDIA B200系列:单GPU约180GB HBM3e内存

Intel Gaudi 3:128GB HBM2e内存

从上述数据可见,高通的产品定位并非以HBM内存容量为竞争点,而是以单卡总内存容量形成差异化优势。

热门优惠券

更多-

- ROTHSCROOSTER旗舰店满49减16

- 有效期至: 2025-01-25

- 立即领取

-

- 萨布森旗舰店满1299减800

- 有效期至: 2025-01-17

- 立即领取

-

- 哲高玩具旗舰店满69减33

- 有效期至: 2025-01-05

- 立即领取

-

- 戴·可·思官方旗舰店满196减27

- 有效期至: 2025-04-01

- 立即领取

-

- 佳婴旗舰店满30减3

- 有效期至: 2025-01-10

- 立即领取

-

- ROTHSCROOSTER旗舰店满19减8

- 有效期至: 2025-01-25

- 立即领取

-

- 荣业官方旗舰店满20减10

- 有效期至: 2025-01-04

- 立即领取

-

- 戴·可·思(Dexter)母婴京东自营旗舰店满48减10

- 有效期至: 2025-01-12

- 立即领取

-

- KOKOROCARE旗舰店满158减100

- 有效期至: 2025-03-28

- 立即领取

-

- RODEL官方旗舰店满59减30

- 有效期至: 2025-01-02

- 立即领取