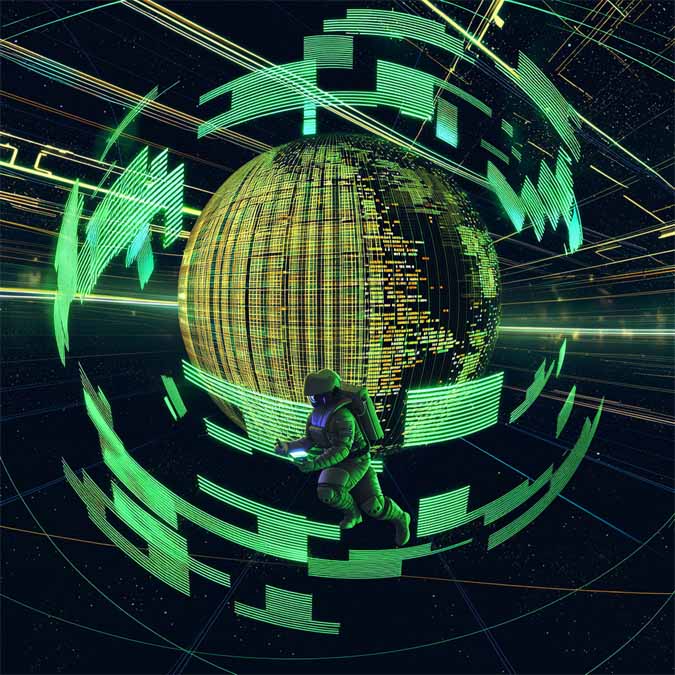

免费且顶配!阿里开源动作生成模型Wan2.2-Animate!

近日,阿里云正式宣布全新动作生成模型Wan2.2-Animate全面开源。从短视频制作到舞蹈模板的批量生成,再到复杂的动漫生产,这一开源模型将为广大开发者与创作者提供巨大的帮助。

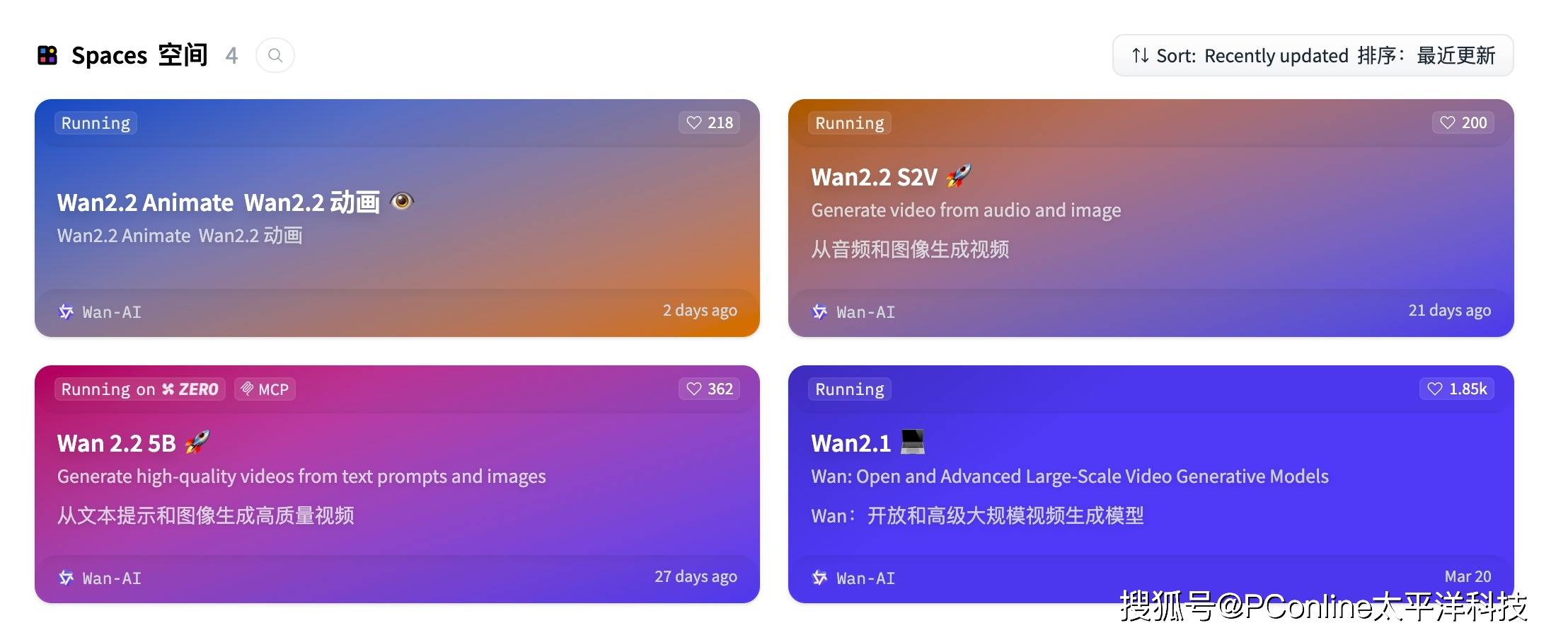

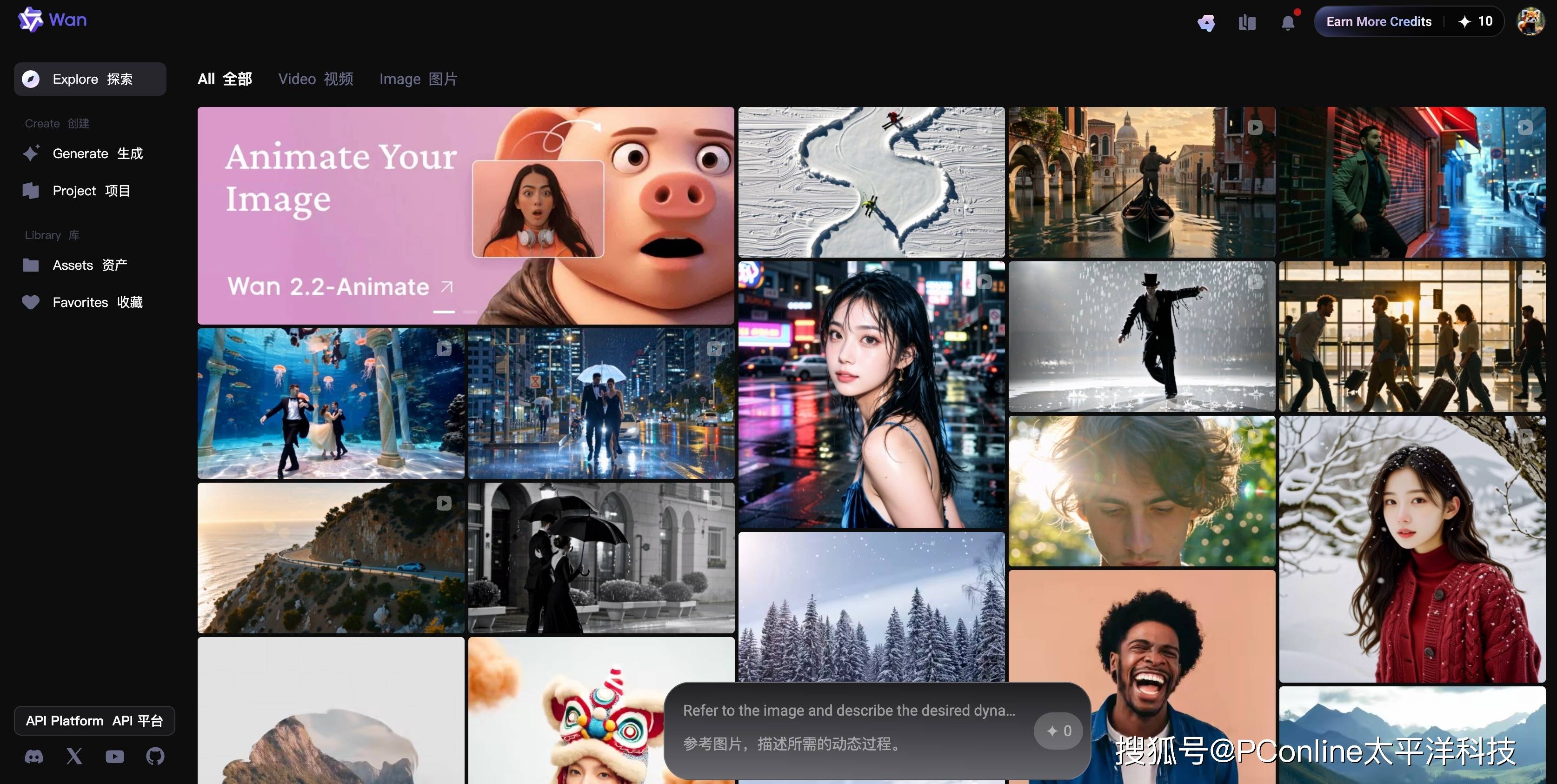

所有对该技术感兴趣的用户,现在均可通过GitHub、HuggingFace以及国内的魔搭社区等主流开源平台,便捷地获取模型及其相关代码。对于希望将其集成到现有工作流或产品的企业和开发者,阿里云百炼平台也已同步上线了相应的API调用服务。而对于普通用户,则可以直接访问通义万相官网,亲身体验其强大的视频生成能力。

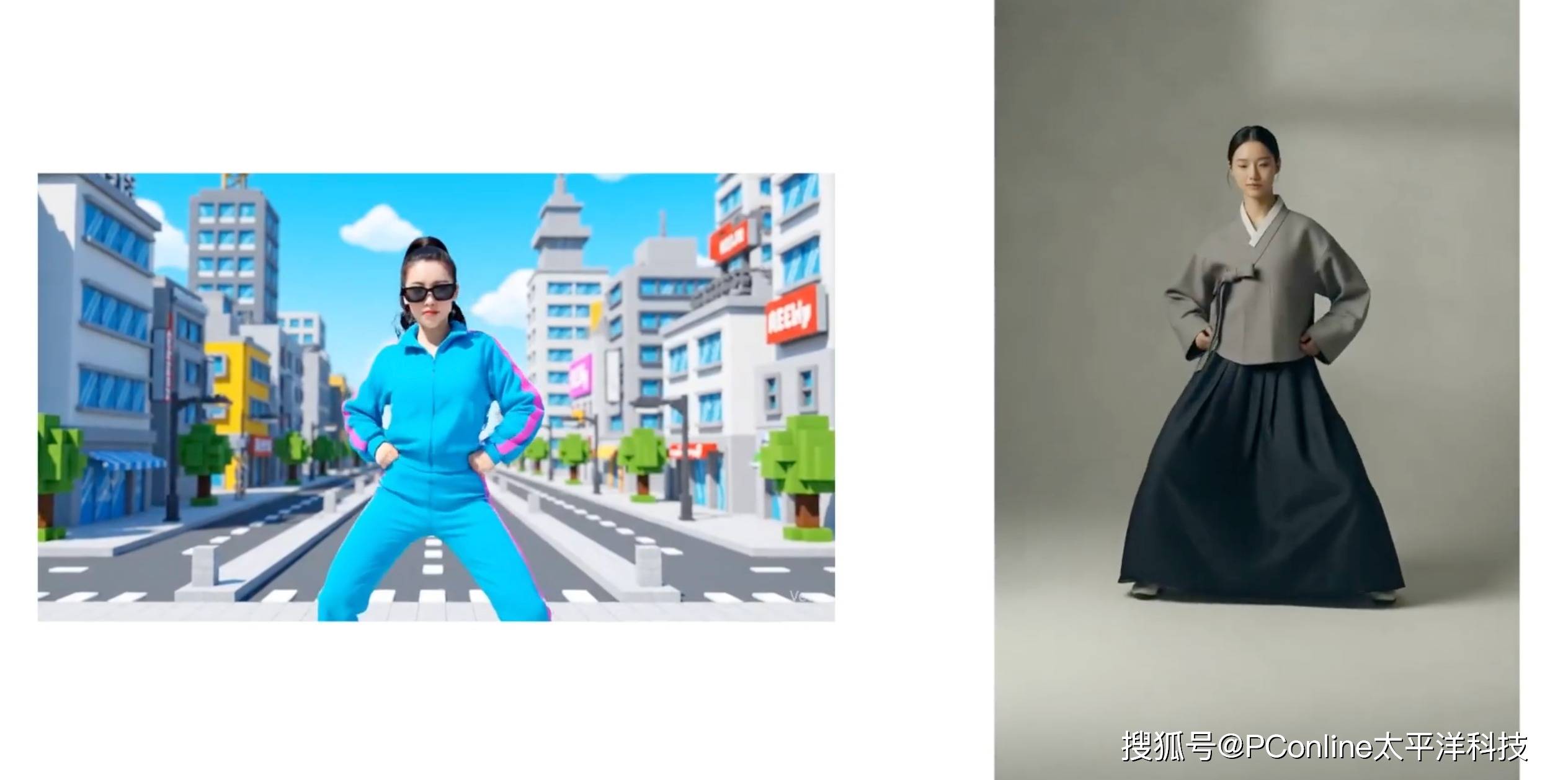

Wan2.2-Animate作为Animate Anyone的迭代升级版,在人物一致性维持与生成视频的整体质量上均实现了显著的飞跃。模型的核心功能围绕两种强大的应用模式构建:动作模仿与角色扮演。在动作模仿模式下,用户仅需提供一张静态的角色图片和一段包含特定动作的参考视频,模型便能精准地将视频中的肢体动作乃至细腻的面部表情,无缝迁移至静态角色之上,使其栩栩如生地动起来。而在角色扮演模式中,模型则能在完整保留参考视频的原始动作、表情乃至环境背景的基础上,将视频中的主角替换为用户指定的全新角色,实现场景与角色的完美融合。

这一系列卓越性能的背后,是通义万相团队坚实的技术创新与数据积累。为了让模型能够精准理解并复现复杂的人类动态,团队专门构建了一个覆盖说话、多样化面部表情及身体动作的大规模、高质量人物视频数据集,并以此为基础,利用通义万相先进的图生视频模型进行了后续的深度训练。

在模型架构设计上,Wan2.2-Animate展现了其精妙之处。它开创性地将角色信息、环境信息与动作信息进行规范化处理,统一至一个共通的表示格式之下,从而以单一模型优雅地兼容了两种核心推理模式。在具体实现上,模型针对身体运动采用了基于骨骼信号的追踪方案,以确保动作的准确性与流畅度;对于面部表情这一精细维度,则通过提取隐式特征进行捕捉。两者结合先进的动作重定向模块,实现了对参考视频动作与表情的高精度复刻。不仅如此,为了应对角色替换模式中光照不一致的难题,团队还专门设计了一个独立的光照融合LoRA模块,确保替换后的角色能够自然地融入新环境的光影之中。

在性能评测中,Wan2.2-Animate的表现不负众望。无论是在视频生成的客观质量、主体身份的一致性维持,还是在感知损失等关键技术指标上,该模型均明显超越了如Stable Animator和Live Portrait等现有主流开源模型,确立了其在当前动作生成领域的领先地位。尤为值得一提的是,在面向用户的多项主观评测中,Wan2.2-Animate的生成效果甚至获得了比肩乃至超越部分业界顶尖闭源模型(如Runway Act-two)的高度评价。

此次阿里云将Wan2.2-Animate毅然开源,无疑将极大地降低高质量动态视频内容的创作门槛,为整个AIGC生态注入强大的创新活力。一个让创意自由驰骋,让每一张图片都能讲述生动故事的新纪元,正加速到来。

热门优惠券

更多-

- ROTHSCROOSTER旗舰店满49减16

- 有效期至: 2025-01-25

- 立即领取

-

- 萨布森旗舰店满1299减800

- 有效期至: 2025-01-17

- 立即领取

-

- 哲高玩具旗舰店满69减33

- 有效期至: 2025-01-05

- 立即领取

-

- 戴·可·思官方旗舰店满196减27

- 有效期至: 2025-04-01

- 立即领取

-

- 佳婴旗舰店满30减3

- 有效期至: 2025-01-10

- 立即领取

-

- ROTHSCROOSTER旗舰店满19减8

- 有效期至: 2025-01-25

- 立即领取

-

- 荣业官方旗舰店满20减10

- 有效期至: 2025-01-04

- 立即领取

-

- 戴·可·思(Dexter)母婴京东自营旗舰店满48减10

- 有效期至: 2025-01-12

- 立即领取

-

- KOKOROCARE旗舰店满158减100

- 有效期至: 2025-03-28

- 立即领取

-

- RODEL官方旗舰店满59减30

- 有效期至: 2025-01-02

- 立即领取